- Marek Zielinski

Rozdzielczość i mit DPI

David by Michelangelo; dithered by User:Gerbrant using own software (cropped from Image:Dithering algorithms.png) [Public domain], via Wikimedia Commons David by Michelangelo; dithered by User:Gerbrant using own software (cropped from Image:Dithering algorithms.png) [Public domain], via Wikimedia Commons |

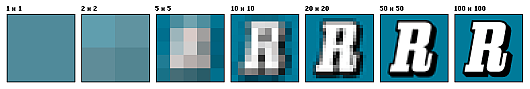

Niezbyt dawno, w czasie rozmowy z archiwistą z Londynu, mieliśmy okazje sprzeczać się na temat dpi plików cyfrowych. Wydawało mi się wtedy, że to zwykłe nieporozumienie, aż do chwili, kiedy inny archiwista z dużej instytucji w Polsce zaczął przekonywać mnie, że filmy 35 mm (negatywy) skanuje się z rozdzielczością 600 dpi. Ponieważ dałoby to skan podobny do rastrowych zdjęć w starych gazetach (używano tam procesu zwanego dithering) - patrz obraz po prawej, byłem nieco zaskoczony. Dało to impuls do napisania tego blogu o dość powszechnej, jak widać, mitologii dpi. O skanie tego negatywu będzie nieco dalej, na początek wstęp o rozdzielczości.

Rozdzielczość

Rozdzielczość optyczna jest pojęciem o ustalonej reputacji pochodzącym z optyki, i w ogólności definiuje, dla danego systemu optycznego, jak daleko muszą być odległe od siebie dwa obiekty (np. dwie równoległe linie), aby dało się je odróżnić - jeśli są za blisko, zmyją się w jeden. Rozdzielczość obiektywów zależy od jakości soczewek i od średnicy soczewki, rozdzielczość błony filmowej od wielkości ziarna itp. Rozdzielczość optyczną wyraża się często w liniach na centymetr. Przy digitalizacji rozdzielczość optyczna jest podstawym parametrem, gdyż określa, jak drobne szczegóły oryginału będą wiernie oddane w zapisie cyfrowym.

Rozpowszechnienie technik cyfrowych wprowadziło inną miarę, nazywaną też rozdzielczością, a określającą liczbę pikseli na które podzielony jest oryginalny obraz, w stosunku do jego fizycznego wymiaru, w czasie konwersji na plik cyfrowy. Dla odróżnienia od rozdzielczości optycznej nazywamy tę miarę Rozdzielczością pikselową (RP), i wyrażamy ją zwyczajowo w pikselach na cal, w skrócie DPI (litera D pochodzi od kropki, ‘dot’). Jeśli więc skanujemy obraz który ma szerokość 2 cali, i dzielimy ten wymiar na 600 elementów, zapisując jasność (kolor) w każdym, to otrzymujemy skan z RP = 300 dpi. Możemy zrobić tak samo w drugim wymiarze (wysokości) i jeśli użyjemy tej samej gęstości, co jest powszechne, to wysokość 3 cali podzielimy na 900 elementów, a piksele będą kwadratowe.

Jak się ma RP do rozdzielczości (optycznej) zależy wyłącznie od wielkości szczegółów na oryginale, które chcemy zachować. Dla ilustracji weźmy arkusz gazety, z notatką napisaną nonparelem. Font ten o wielkości 6 p. ma ok 2 mm (0.08 cala) wysokości. Ile pikseli potrzeba aby móc ten tekst odczytać? Z ilustracji poniżej widać, że przy 20 pikselach daje się już literę z pewnym wysiłkiem odcyfrować, ale 50 pikseli pokaże ją lepiej. Daje to 250 dpi (= 20 / 0.08) minimum, 625 dpi (= 50 / 0.08) optymalnie.

Ilustracja rozdzielczości (z Wikipedii).

RP jest prostym stosunkiem liczby pikseli N w jednym wymiarze do długości oryginału L. Długość wyrażamy tradycyjnie w calach, choć można łatwo przeliczyć na centymetry.

RP = N / L

Z powyższego wynika również wprost, że w odłączeniu od oryginału, plik cyfrowy obrazu nie posiada RP. Jest to szczególnie jasno widoczne dla zdjęć cyfrowych. Zdjęcie odzwierciedla świat trójwymiarowy na dwuwymiarowym czujniku optycznym, i choć znamy liczbę pikseli (reklamowaną w aparatach jako megapiksele), to nie istnieje szerokość czy wysokość oryginalnego obrazu, gdyż brak tego obrazu. Podobnie jest z każdym innym obrazem cyfrowym - RP odnosi się wyłącznie do procesu konwersji, jeśli skanowaliśmy płaski obiekt, nie do końcowego, przetworzonego obrazu.

Rastrowa grafika cyfrowa (np. zdjęcie w pliku tiff, jpg czy png), charakteryzuje się tylko wymiarami podanymi w pikselach. Plik może mieć 100 x 100 pikseli (kwadratowy) albo 3000 x 2000 pikseli (w proporcji 3:2). Rozmiar na dysku jest proporcjonalny do iloczynu tych dwóch wymiarów jeśli nie uległ kompresji (kompresja może zmniejszyć rozmiar wielokrotnie). Rozdzielczość obrazu albo optyczna zależy tylko od tego, jak drobne szczegóły są w tym obrazie zawarte, albo ile pikseli jest użyte dla zobrazowania najmniejszego szczegółu. Nieostre zdjęcie o wymiarze 3000 pikseli może mieć mniejszą rozdzielczość niż identyczne ale ostre zdjęcie o wymiarze 1000 pikseli.

Jakby w zaprzeczeniu stwierdzenia, że plik cyfrowy nie ma dpi, programy do obróbki obrazów rastrowych, takie jak photoshop, i zapisy w danych plików graficznych (np. EXIF) używają RP do charakteryzacji pliku. Dlaczego tak jest, dowiemy się w drugiej części, o magii 72.

Magia 72

W dobie druku na papierze istniała potrzeba ustalenia standardowych rozmiarów czcionek tak, aby drukarz mógł wybrać z kaszty zecerskiej odpowiedni rozmiar. W roku 1737 Perre Simon Fournier wprowadził standard, oparty na stopie francuskiej, wkrótce (w 1775) zamieniony przez François-Ambroise Didota na stopę paryską. System Pica, używany w USA oparty jest na stopie typograficznej (różnej od stopy anglosaskiej), gdzie jedna pica to 1/72 stopy (a w nowszym systemie Postscript 1 punkt to 1/72 cala). Pierwsze monitory komputerowe miały rozdzielczość 72 kropek na cal (dpi). Pozwalało to na wyświetlenie czcionek o wielkości 10 punktów lub większych, choć nawet przy 10 p. rozdzielczość, szczególnie małych liter, była słaba.

Manipulacja definicjami pochodzi już z tego okresu. Aby poprawić czytelność liter, Microsoft założył, ze rozdzielczość ekranu jest 96 dpi (bez zmiany rzeczywistej rozdzielczości ekranów) co pozwoliło na zwiększenie rozmiaru czcionek o ⅓. Od tej pory te same ekrany używane w PC były traktowane jako ekrany 96 dpi, a w Apple jako ekrany 72 dpi.

Ten trend naginania definicji pozostał do dziś w określaniu RP w plikach cyfrowych. Zdjęcie, które robię kamerą (Canon) o wielkości sensora 10 megapikseli ma wymiary 3888 na 2592 pikseli i zajmuje 28.8 MB pamięci a na dysku, a po kompresji ok 3.8 MB. Ale w danych EXIF zapisanych przez kamerę, jest również RP. Jaka ona jest? Można się już domyśleć, że jest to zupełnie fikcyjna wartość RP = 72 dpi. Po prostu wszystkie kamery propagują tę fikcję ustalając ten parametr na tradycyjnej magicznej wartości 72. Z równania RP = N / L można oczywiście obliczyć wymiar, i dla dłuższego boku tego obrazu otrzymujemy 1372 mm (o 15% większy od papieru format A0). Ponieważ równanie ma 3 zmienne, więc każde dwie wystarczą, aby obliczyć trzecią. np. N i L, albo RP i N, albo RP i L.

Jaki jest powód propagowania tej fikcji? Nie jest to jasne, ale podejrzewam, że przyzwyczajenia wymierają bardzo powoli, i tak, jak w Polsce używamy systemu Didota z 1775 opartego o stopę paryską, tak ludziom pracującym w grafice trudno się rozstać z mitem dpi.

Jaka jest więc odpowiedź na zagadkę z początku artykułu? Koledzy z dużej Instytucji w Polsce skanują używając fikcyjnej RP w wielkości 600 dpi, ustawiając jednocześnie “docelowy” fikcyjny rozmiar na 150 mm. Program posłusznie i po cichu przelicza, używając rozmiaru klatki negatywu (35 mm), że rozdzielczość powinna być 150/35 = 4.3 raza większa, i skanuje z RP = 2571 dpi. Ponieważ jest to rozdzielczość w granicach możliwości skanera, więc skaner nie musi robić interpolacji, i wynik jest bliski pożądanemu. Przypomina to trochę pytanie, z jaką szybkością jadę samochodem z Łodzi do Warszawy. Mój samochód jedzie z szybkością 5 milimetrów na godzinę i dojeżdża do Warszawy w 3 godziny. Jest to oczywiście możliwe, jeśli fikcyjna prędkość 5 mm/godz jest obliczana używając odległości z mapy Polski w skali 1 do miliona.

Skala ekranu

Być może RP ma jakiś sens przy określaniu, jak są one pokazywane na ekranie - w końcu ekran ma swoje fizyczne wymiary? Ekrany produkowane dziś maja jednak różne wielkości i różną rozdzielczość. Szerokie ekrany komputerowe maja RP w granicach 95 - 110 dpi. Mniejsze ekrany tabletów - 220 do 260 dpi, nowe telefony komórkowe ponad 300 dpi. Rozdzielczość jest zwykle dopasowana do typowej odległości, z której się ogląda obraz. Co więcej, wszystkie obrazy są teraz skalowane przez oprogramowane tak, aby zmieściły się w jakimś prostokącie używanym do ich wyświetlania. Co więcej, po obróceniu obrazu o 90 stopni, zmienia się jego skala a więc ‘pozorne dpi’. Tak więc nawet i w tym przypadku powinniśmy się pożegnać z mitem dpi.

Podsumowanie

Obrazy w postaci cyfrowej należy charakteryzować wymiarem w pikselach (zwykle używa się dłyższego z dwóch wymiarów, albo wymiaru w poziomie). Typowe wymiary to 320 pikseli (nadaje sie do emailu), 640, 800 (rozmiary dawnych monitorów), 1200, 1600 itp. pikseli. Oryginalne zdjęcia robione aparatem cyfrowym mają 4000 pikseli lub więcej.

- Rozdzielczość to możliwość rozróżnienia szczegółów w obrazie na który patrzymy. Rozdzielczość optyczna może być wyrażona w liczbie linii na centymetr.

- Przy wykonywaniu skanu (lub fotografii cyfrowej) płaskiego obiektu, używamy parametru który określa, na ile pikseli podzieliliśmy dana długość (osobno w dwóch wymiarach). Parametr ten nazywa się rozdzielczością w pikselach (RP) i wyrażany jest w pikselach na cal, w skrócie dpi.

- Formuła która określa RP to RP = N / L, gdzie N to liczba pikseli obrazu cyfrowego a L to wymiar oryginalnego obiektu.

- Plik cyfrowy charakteryzuje się (m.in) wymiarami w pikselach w dwóch wymiarach, ale nie posiada RP ani L.

- Opierając się na rozmiarze w pikselach N, można plikowi przypisać dowolną kombinację rozdzielczości pikselowej RP i wymiaru L, takich, że N = RP * L. Te pary N i L mogą być wybrane w sposób arbitralny.

- Obrazy są zawsze skalowane na ekranie (komputera, tableta, telefonu itp.).

- Przy używaniu oprogramowania graficznego należy zwracać szczególną uwagę na parametry RP, L i N, gdyż zmiana jednego z nich może prowadzić do niespodziewanych wyników, w zależności o tego, który z pozostałych program traktuje jako stałą.

Czytaj więcej

- Artykuł w Wikipedii po angielsku opisujący dpi

- Artykuł w Wikipedii po polsku błędnie rozpowszechniający mit dpi

- Artykuł w Wikipedii o czcionkach zecerskich

- Rozdzielczość obrazu - artykuł w Wikipedii po angielsku

- Powiedz "NIE" 72 dpi - artykuł Wayne Fulton

Marek Zieliński, 15 czerwca 2013

Może Cię też zainteresować:

- Iza, Zosia i Atom odwiedzają archiwa

- Pamięć masowa dla archiwów cyfrowych

- Unikalne identyfikatory w archiwach i bibliotekach

{plusone}